페이스북 멀티모달 방식의 AI 모델 Image bind 발표

페이지 정보

관련링크

본문

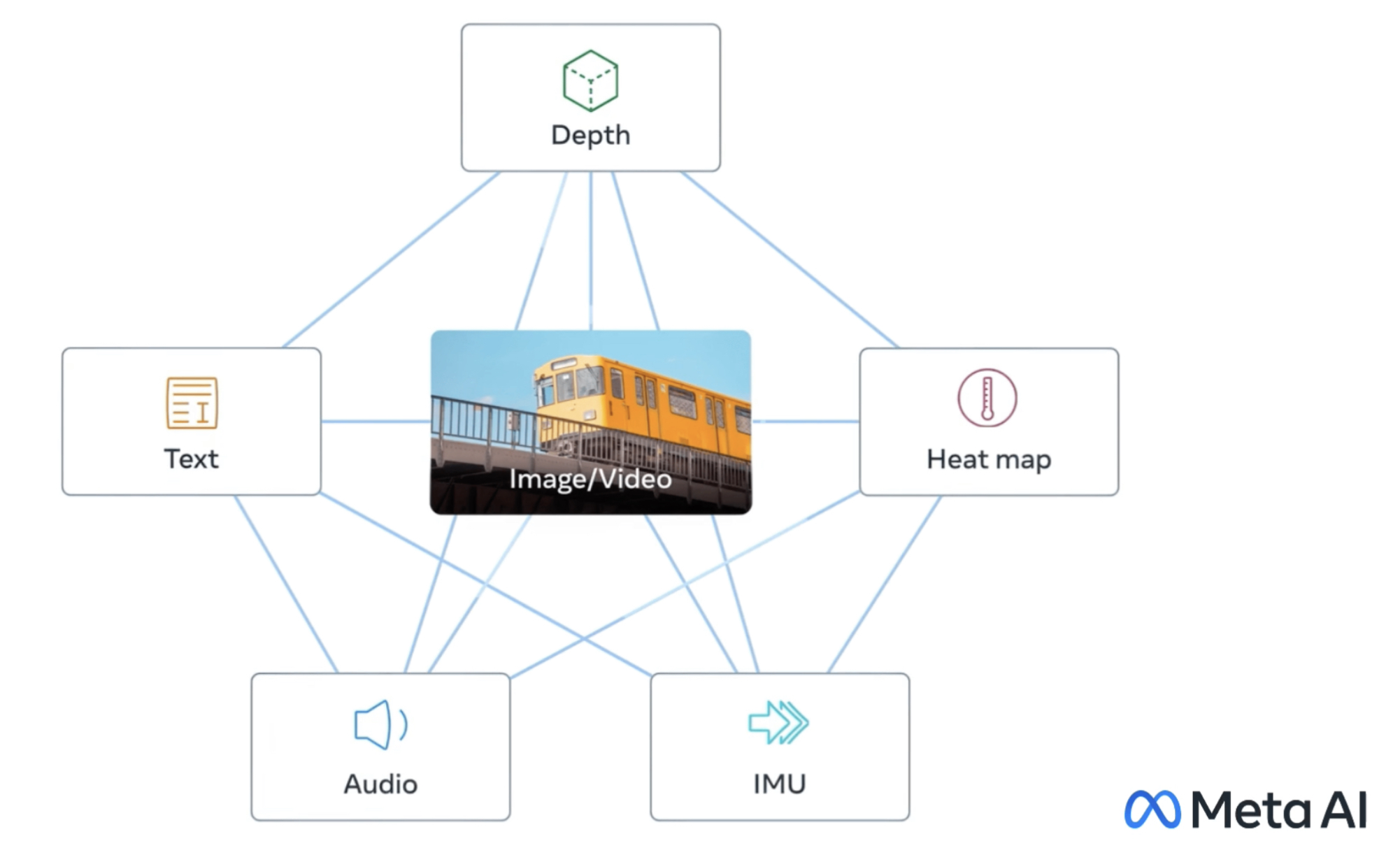

이미지로 콘텐츠를 바인딩하여 단일 임베딩 공간 학습

인간은 단지 몇 가지 예로부터 새로운 개념을 배울 수 있는 능력을 가지고 있습니다.

우리는 일반적으로 동물에 대한 묘사를 읽고 그것을 실생활에서 인식할 수 있습니다.

우리는 또한 낯선 자동차 모델의 사진을 보고 엔진 소리가 어떻게 들릴지 예상할 수 있습니다.

이것은 부분적으로 하나의 이미지가 사실 전체 감각 경험을 "결합"할 수 있기 때문입니다.

그러나 AI 분야에서는 양식의 수가 증가함에 따라 다중 감각 데이터가 부족하면 쌍체 데이터에 의존하는 표준 멀티모달 학습을 제한할 수 있습니다.

이상적으로는 다양한 종류의 데이터가 분산된 단일 공동 임베딩 공간을 통해 모델이 다른 양식과 함께 시각적 특징을 학습할 수 있습니다.

이전에는 모든 양식에 대해 이러한 공동 임베딩 공간을 학습하려면 쌍으로 구성된 데이터의 가능한 모든 조합을 수집해야 했습니다. 이는 실현 불가능한 기능입니다.

ImageBind는 최근의 대규모 비전 언어 모델을 활용하고 비디오 오디오 및 이미지 깊이 데이터와 같은 이미지와의 자연스러운 페어링을 사용하여 단일 공동 임베딩 공간을 학습함으로써 제로샷 기능을 새로운 양식으로 확장함으로써 이 문제를 회피했습니다.네 가지 추가 양식(오디오, 깊이, 열 및 IMU 판독값)의 경우 자연스럽게 쌍을 이룬 자체 감독 데이터를 사용합니다.

인터넷에서 이미지와 동시에 발생하는 텍스트가 풍부하기 때문에 이미지 텍스트 모델을 훈련하는 것은 광범위하게 연구되어 왔습니다.ImageBind는 이미지의 바인딩 속성을 사용합니다.

즉, 다양한 양식과 동시에 발생하며 웹 데이터를 사용하여 텍스트를 이미지에 연결하거나 IMU 센서로 웨어러블 카메라에서 캡처한 비디오 데이터를 사용하여 모션을 비디오에 연결하는 등 이미지를 연결하는 브리지 역할을 할 수 있습니다.

대규모 웹 데이터에서 학습한 시각적 표현은 다양한 양식에 대한 기능을 학습하는 대상으로 사용할 수 있습니다.

이를 통해 ImageBind는 이미지와 동시에 발생하는 모달리티를 정렬하여 자연스럽게 해당 모달리티를 서로 정렬할 수 있습니다.

열 및 깊이와 같이 이미지에 대한 상관 관계가 강한 모달리티는 정렬하기가 더 쉽습니다.

오디오 및 IMU와 같이 시각적이지 않은 양식은 상관 관계가 더 약합니다.

아기의 울음소리와 같은 특정한 소리가 여러 시각적 맥락에 따라 발생할 수 있다는 점을 고려합니다.

이미지 바인딩은 이미지 쌍 데이터가 이 여섯 가지 양식을 결합하기에 충분하다는 것을 보여줍니다.

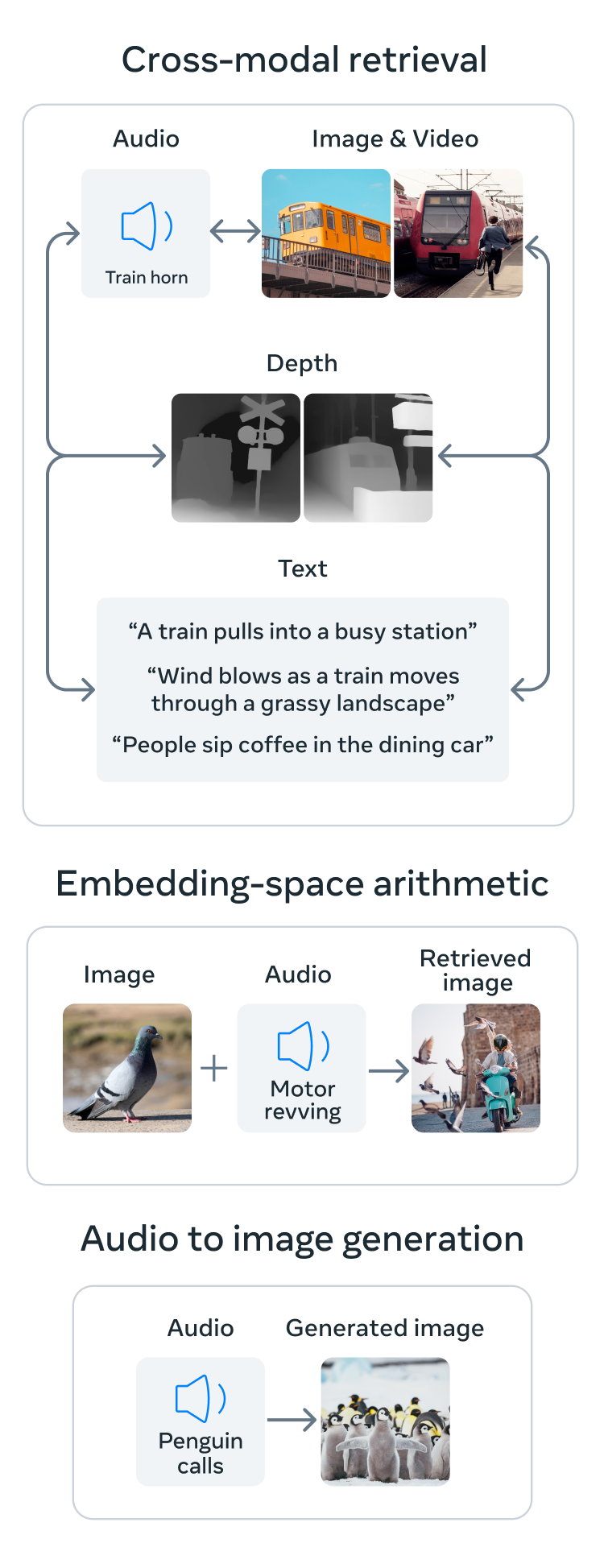

이 모델은 내용을 보다 전체적으로 해석할 수 있으므로, 서로 다른 양식이 서로 "대화"하고 함께 관찰하지 않고 링크를 찾을 수 있습니다.

예를 들어 ImageBind는 오디오와 텍스트를 함께 보지 않고 연결할 수 있습니다.

이를 통해 다른 모델은 리소스 집약적인 교육 없이도 새로운 양식을 "이해"할 수 있습니다.

ImageBind의 강력한 확장 동작을 통해 모델은 다른 양식을 사용할 수 있게 함으로써 많은 AI 모델을 대체하거나 향상시킬 수 있습니다.예를 들어 Make-A-Scene은 텍스트 프롬프트를 사용하여 이미지를 생성할 수 있지만 ImageBind는 웃음이나 비와 같은 오디오 사운드를 사용하여 이미지를 생성하도록 업그레이드할 수 있습니다.

기사 : https://v.daum.net/v/20230510144127267

메타전문 : https://ai.facebook.com/blog/imagebind-six-modalities-binding-ai/