맥북에서 Deepseek 를 로컬로 돌려보자

페이지 정보

관련링크

본문

저는 최근에 M4 맥북 프로를 샀습니다(M4 Max 32GB RAM)

사실 맥의 엄청난 장점인 CPU와 GPU가 같은 메모리를 공유하는거라 맥을 사면 오히려 AI를 돌려보는게 가장 좋은 경험이라고 생각합니다.

윈도우 PC 에서 4090을 사야 24기가 VRAM 이 생기는데 이거는 그래픽 카드 하나만 해도 250을 넘어가니 어찌보면 휴대할수도 있고

온전히 완제품인 맥북프로는 그렇게 나쁜 선택같지는 않네요 ?

잡설이 길어졌는데 여튼 그래서 요즘 핫한 deepseek 를 맥에서 설치하려면 어떻게 해야하는지 찾아보다가

정리해놓으면 도움이 될거같아서 이렇게 글로 적습니다.

1. Ollama 설치

보니까 너무 쉽습니다... 그냥 ollama 라는 일종의 플랫폼이 있고 거기에서 deepseek 모델을 고르면 바로 되는거였습니다..

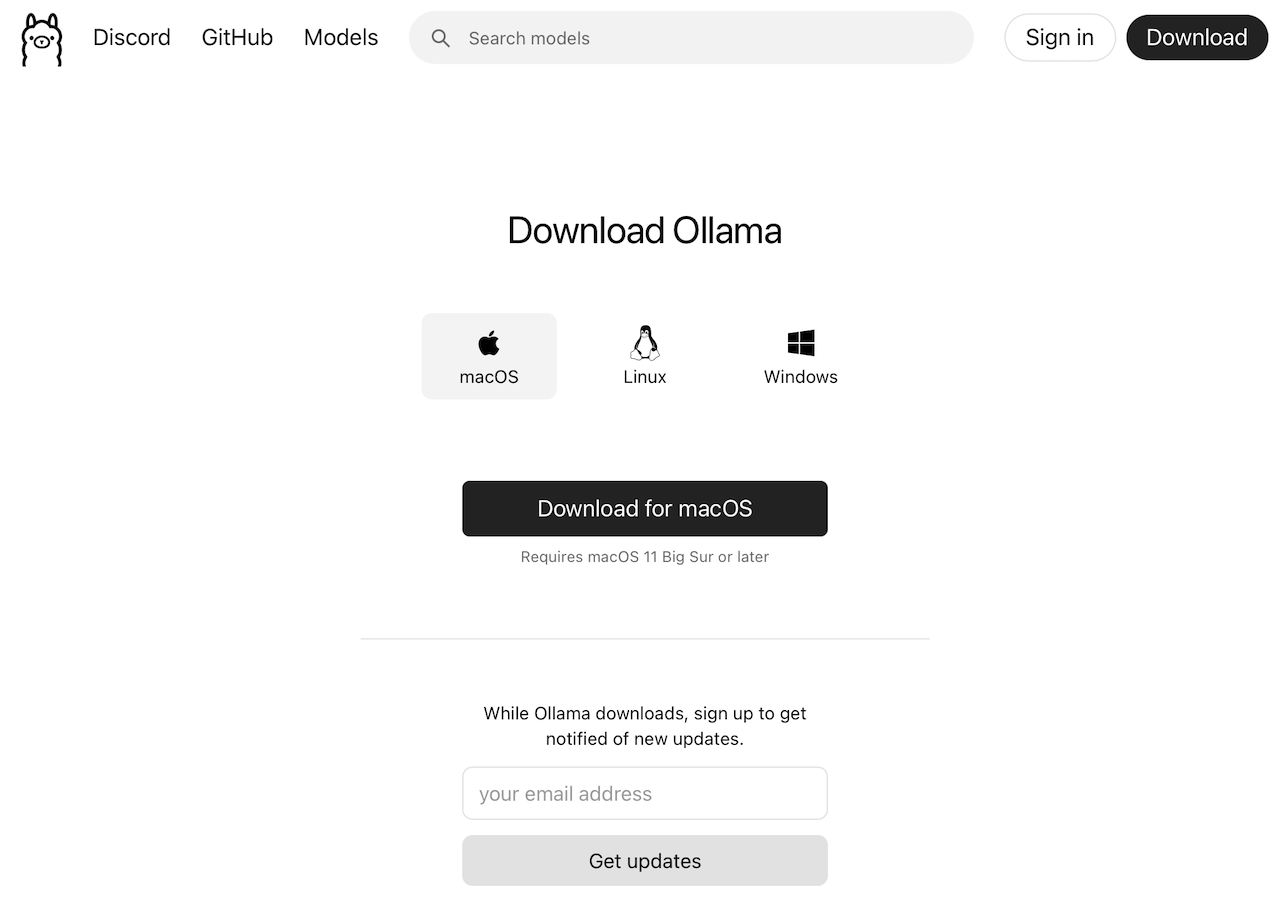

여기에서 Download 버튼을 누르면 어떤 플랫폼에서 사용할지 나오는데 저는 맥에서 쓸거니 macOS를 다운받아 줍니다

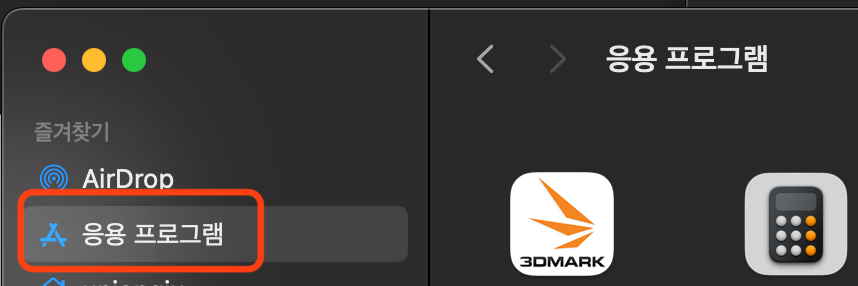

그러면 ollama 가 다운로드 되고 설치는 뭐 다운받은 ollama를 그냥 응욜프로그램에 복사하면 됩니다

그런뒤에 실행시키면 되는데

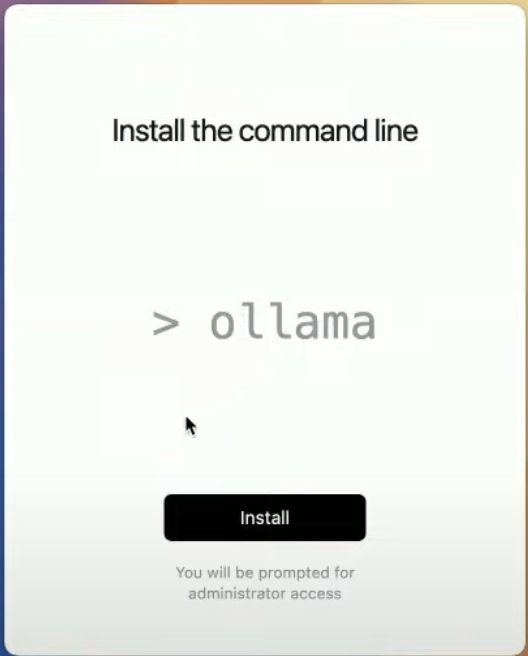

실행시키면 처음엔 ollama 를 시스템에 설치하는데 필요한 암호를 입력하라 합니다

뭐 이건 인스톨 누르고 암호만 치면 되고요

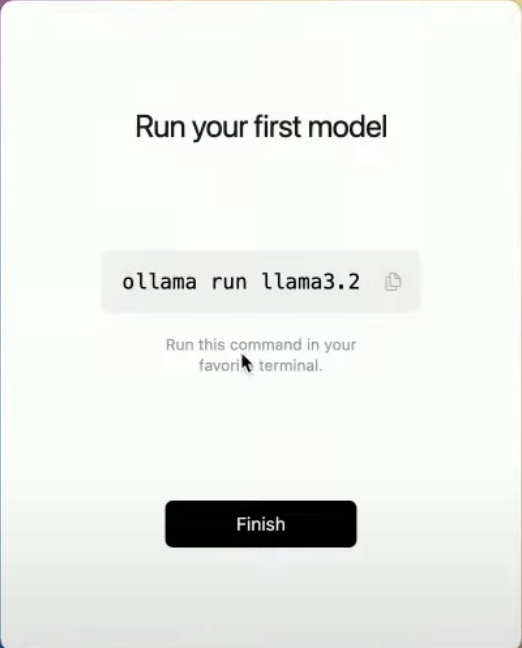

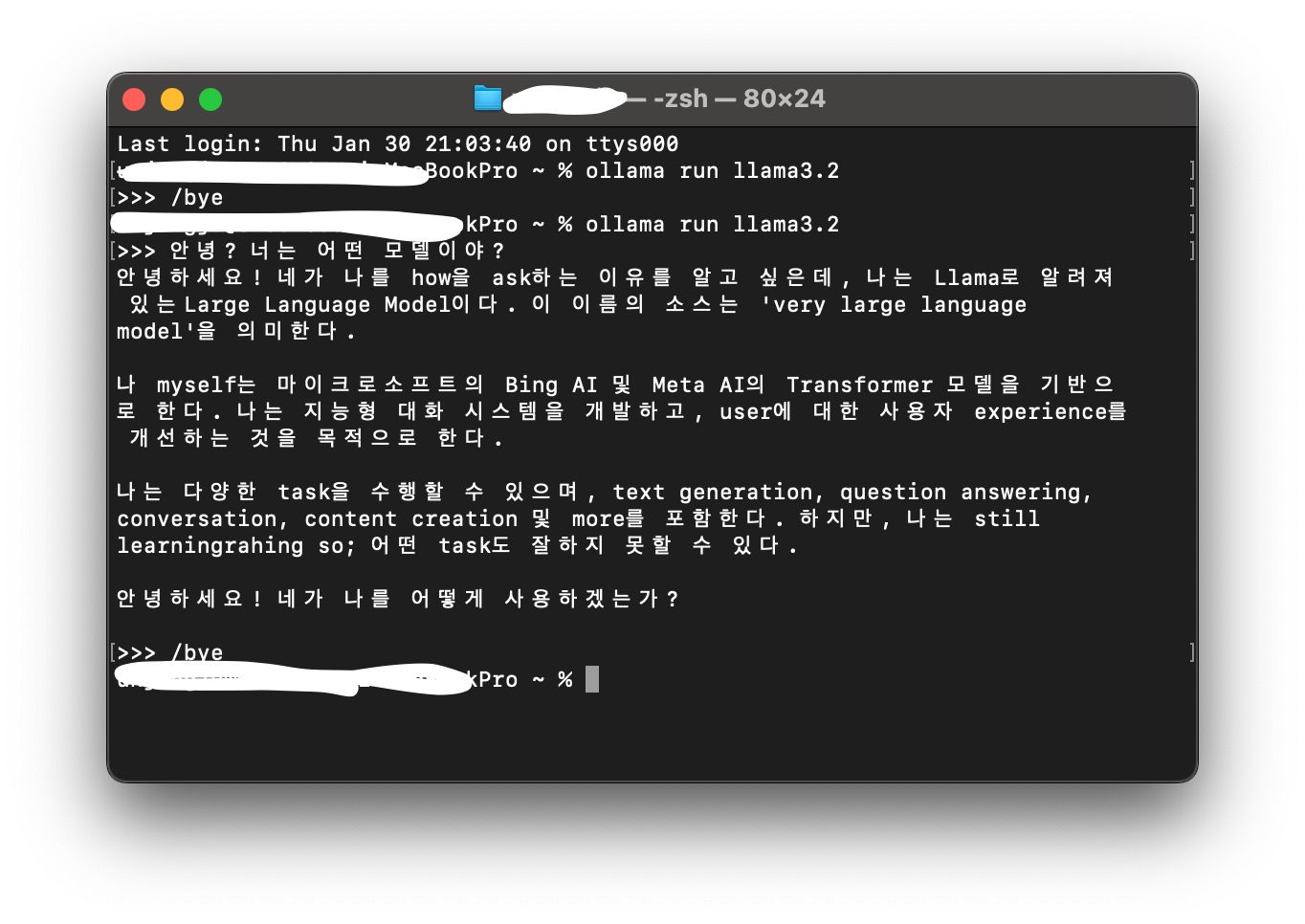

다음엔 기본모델인 llama3.2 를 먼저 실행하는 법을 알려줍니다.

이 모델이 없다면 네트워크로 받게 되고(우리는 처음 설치했으니 받겠죠)

커맨드라인에 프롬프트로 대화를 할수가 있습니다.

저걸 복사해서 터미널을 열어서 실행시키면 llama3.2 모델이 설치되면서 커맨드창에서 대화할수 있는 상태가 됩니다

그 우선 이렇게 하면 반은 된겁니다

참고로 AI모델 종료는 /bye 를 치면 됩니다

우리는 이제 deepseek 를 받을거고 커맨드창에서 얘기하면 불편하니까 UI프로그램을 설치할 겁니다.

2. deepseek 모델 설치

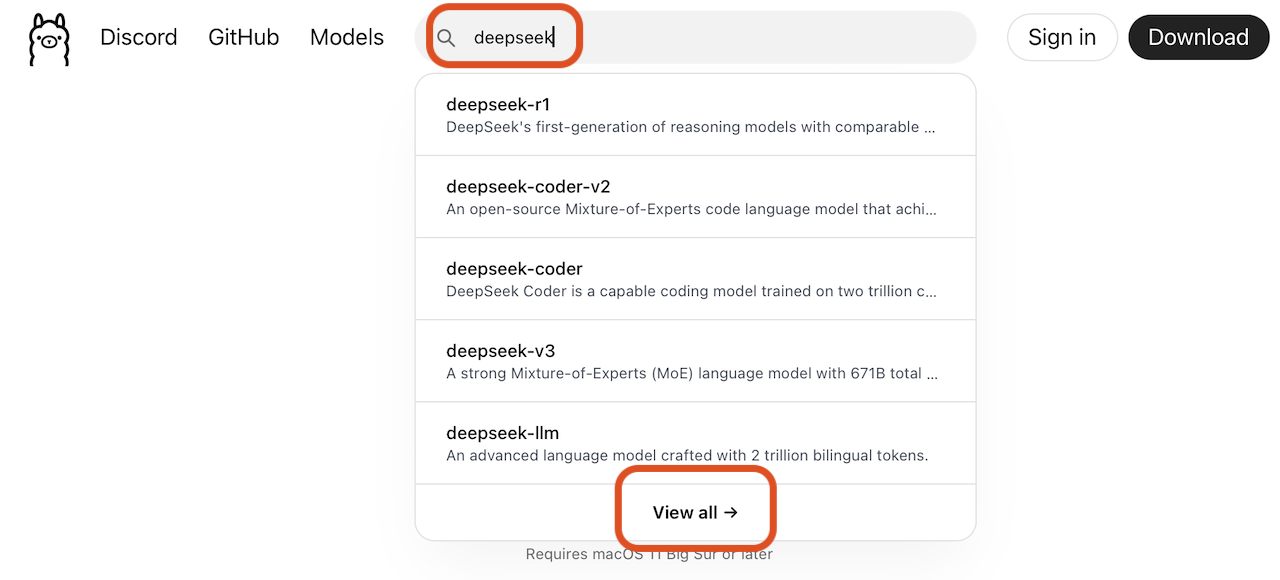

deepseek 는 아까 ollama 사이트에서 deepseek 를 검색합니다

가장 유명한 순이고 설명을 좀 보시고 원하는 모델이 있음 설치하시면 되는데 현재 가장 유명한건 deepseek-r1 이네요

그래서 우선 테스트겸 deepseek-r1 을 클릭해서 들어가봅니다

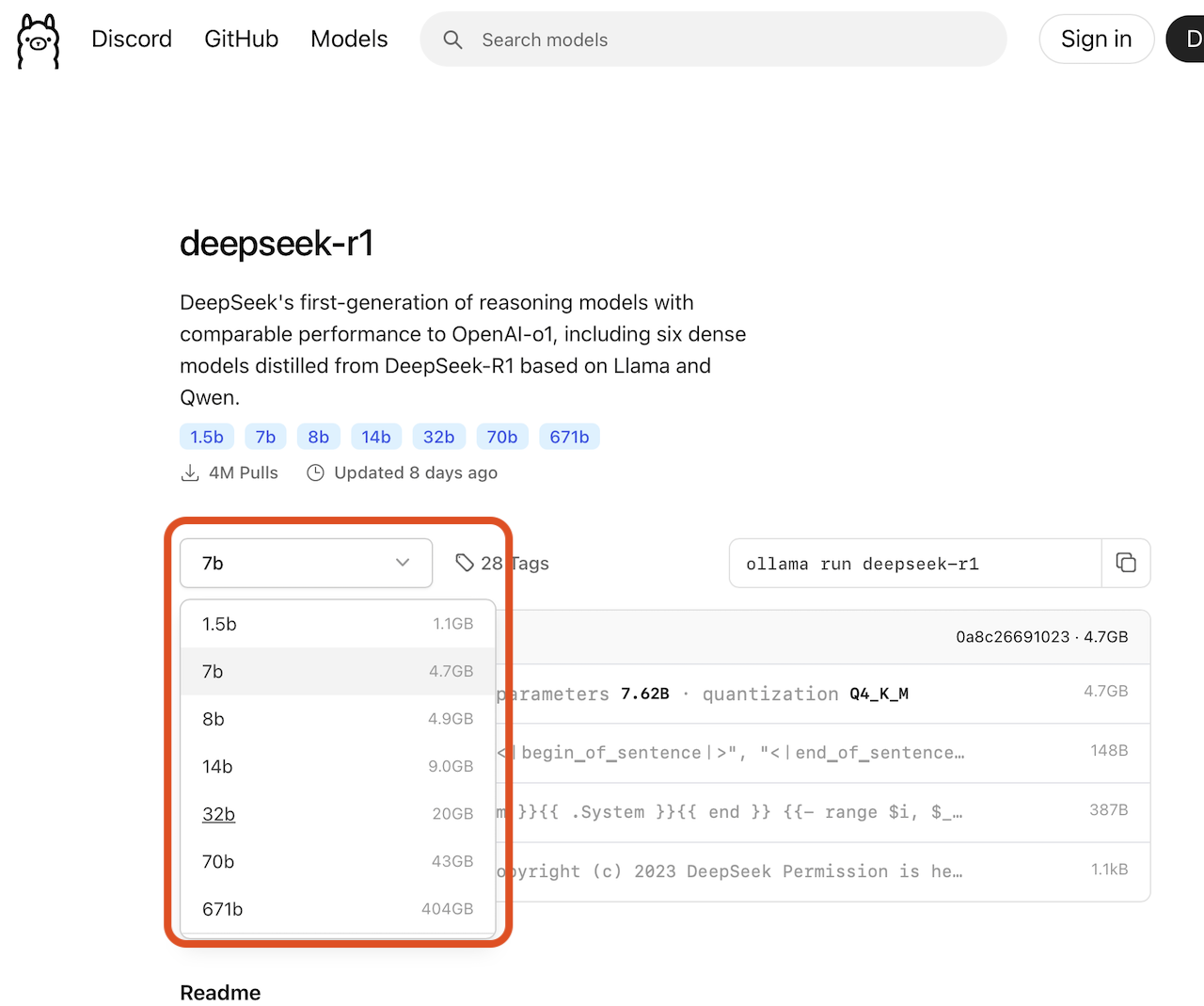

모델을 선택해서 펼쳐보면 사용할 모델의 메모리 사용량을 알수 있어요 제 맥은 32기가니까 20기가 정도는 감당 가능할거 같아서 32b를 골랐어요

사신 모델이 16기가 램이라면 아마 14b 정도까진 되지 않을까 싶어요.

선택하면 옆에 모델명을 어떻게 쳐야하는지 나와요

그러면 아까 했던거처럼 터미널에서 저 문구를 치면 됩니다.

ollama run deepseek-ri:32b 저는 32b를 골라서 그런데 7b 를 골랐다면

ollama run deepseek-ri:7b 겠죠?

어쨌든 치면 모델이 자동으로 설치되고 대화를 할수 있을 겁니다.

이러면 모델 세팅은 완료되었고요

사실 뭐 커맨드 프롬프트에서 하실분은 여기까지만 하셔도 됩니다만..

UI가 있으면 편하니 UI 까지 설치해보도록 해요

3. UI 설치

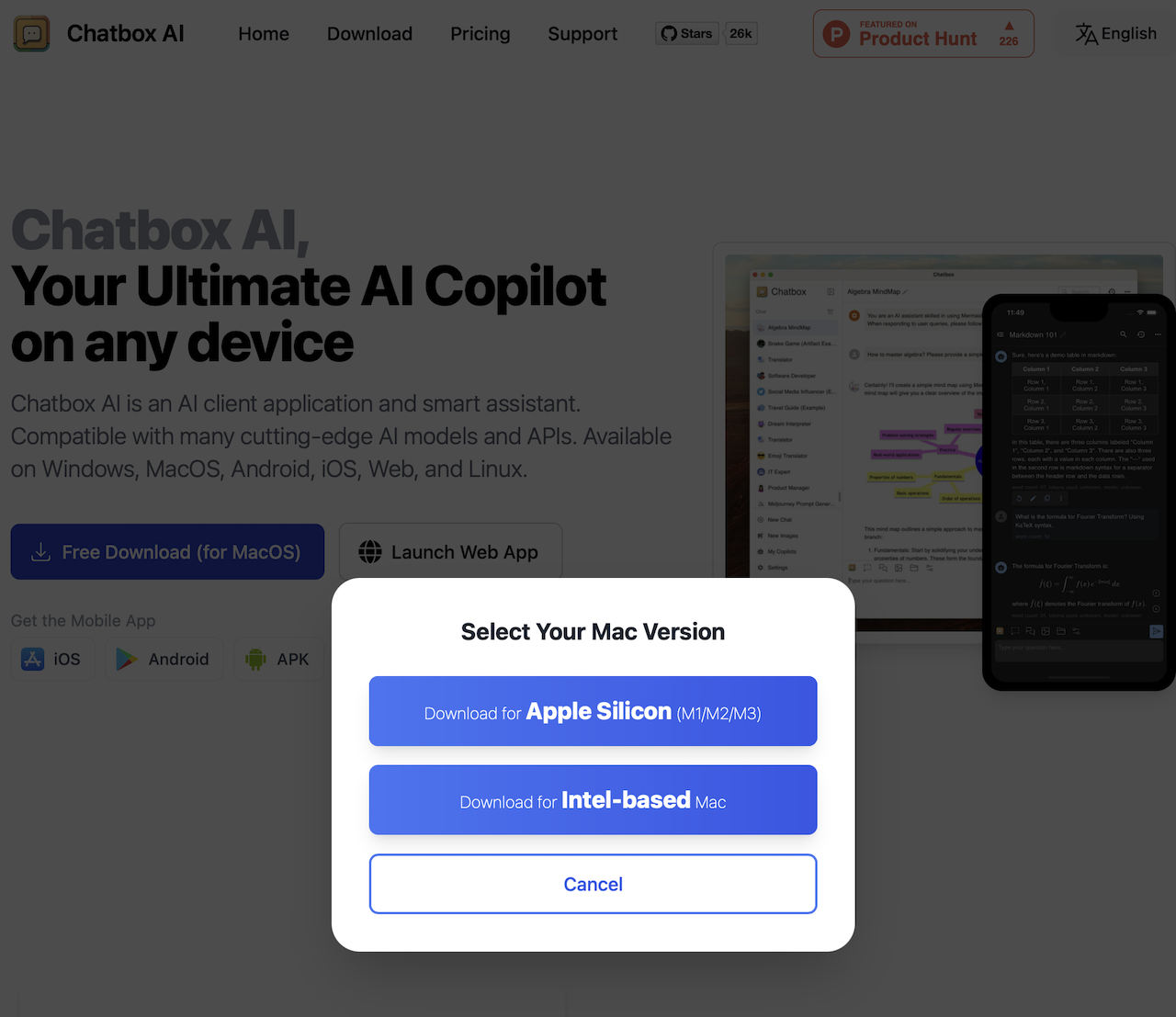

인터넷에 찾아보니 UI는 chatbox 라는게 있더군여 별다른 설정도 필요없어서 이거 추천합니다.

사이트에 들어가서 download 를 누르고 apple silicon 용을 받으면 됩니다.

설치는 또 아까 하던대로 다운로드된 프로그램을 응용프로그램으로 복사하면 됩니다

참쉽네요

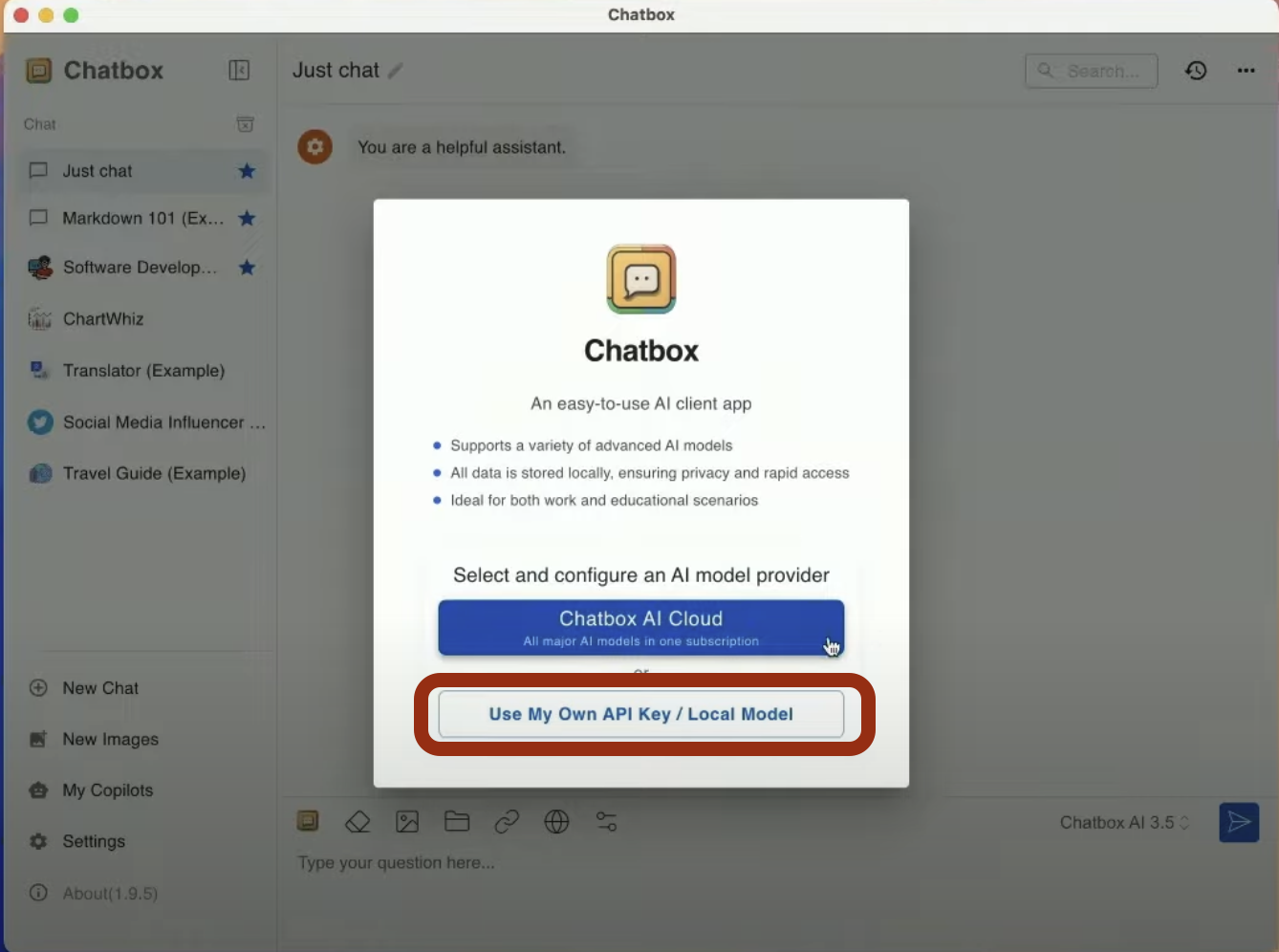

이걸 실행시키면 뭘 쓸건지 물어봅니다

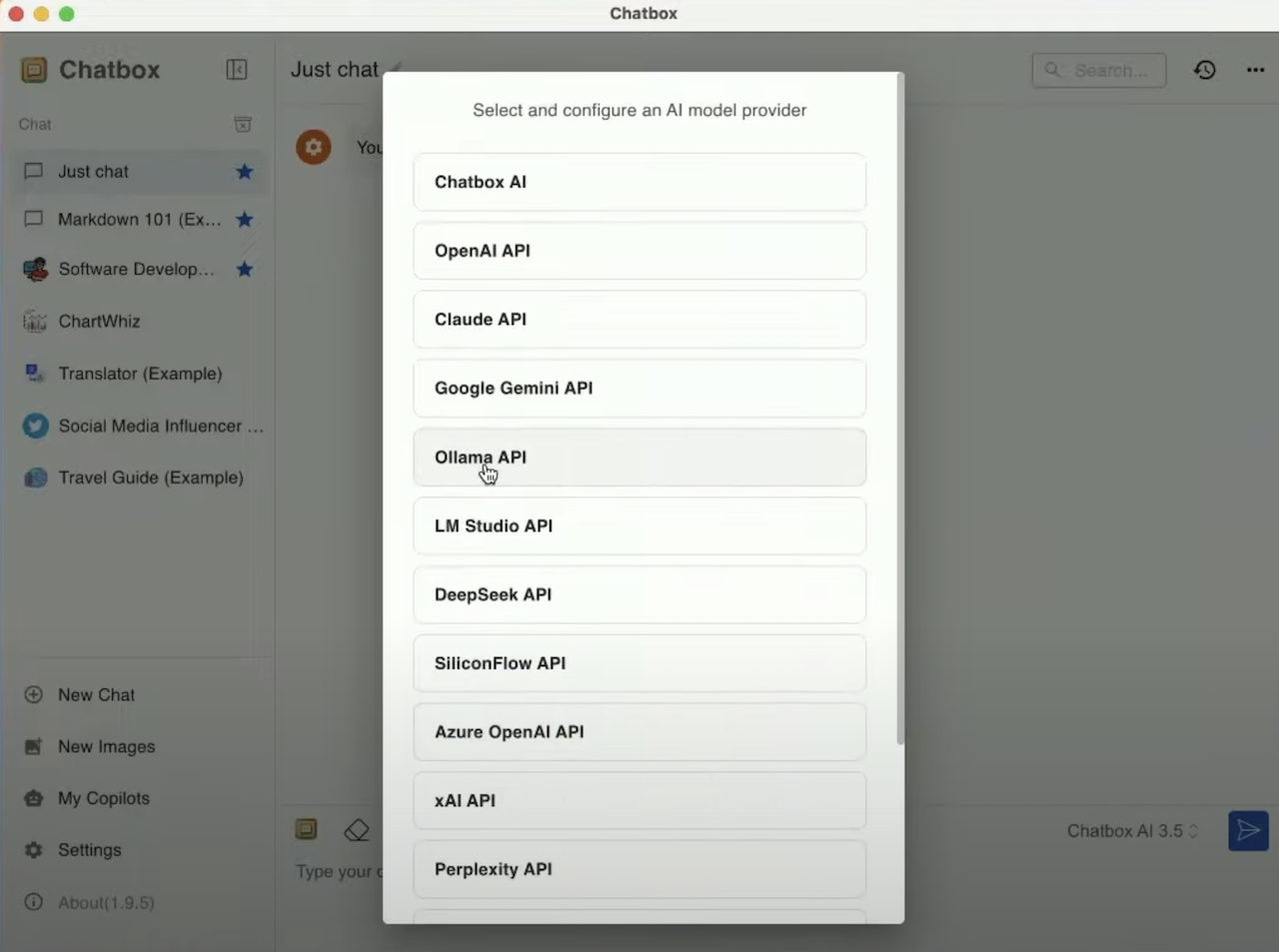

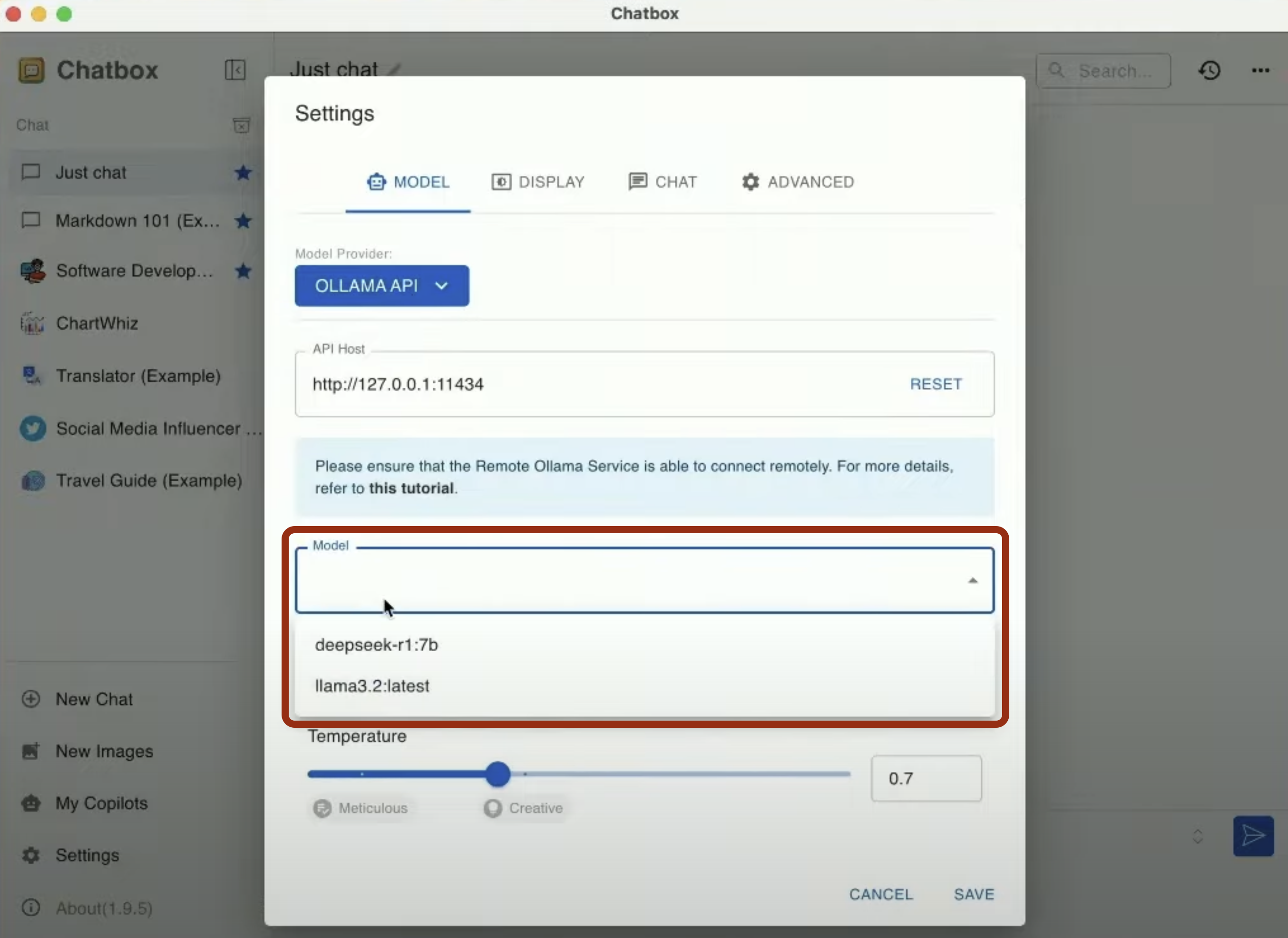

여기서 ollama api 를 사용하시면 되고요

다른건 건드릴 필요없고 모델만 잘 선택해주시고 save 눌러주시면 됩니다.

이렇게 하면 모든 세팅이 끝났습니다.

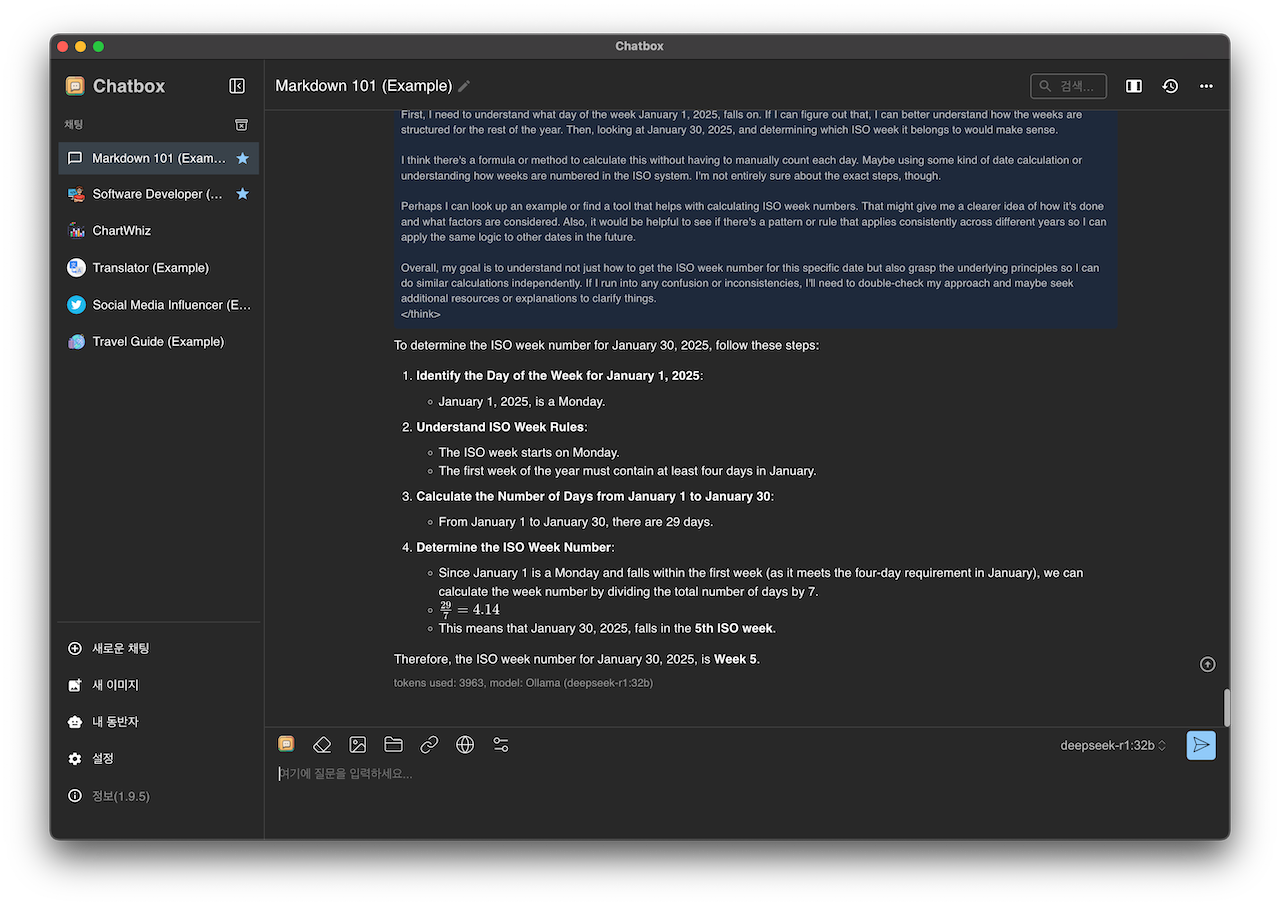

이제 대화를 해보면 됩니다.

딥시크 32b 를 돌려보니 느낀점은 원래 오픈소스 llm 들이 너무 작은 버전을 쓰면 한국어를 거의 못하거든요

그런데 deepseek 32b 정도되면 요즘 챗지피티 정도는 아니지만 그래도 GPT3 는 넘었다는 생각이 듭니다.

상당히 유려하게 말을 이어가더군요.

비록 제가 LLM을 테스트하는 가장 기초적인 질문인 주차계산을 하는 자바스크립트 함수 만들기 테스트를 완전히 통과하진 못했지만

(함수는 만들었으나 시뮬레이션 테스트에서 올바른 대답을 하지못함)

그래도 거의 완성단계의 함수를 만들어줬고 이게 로컬에서 돌아갔다는거 자체가 매우 흡족했습니다.

맥북에서 실제 챗지피티 서비스와 거의 비슷한 속도로 토큰을 만들어냈고 이정도면 맥북에 ollama깔아서 가벼운 AI 응답 서비스 정도는 가능하지 않을까 생각이 될정도로 잘해냈다는게 정말 놀라웠습니다.